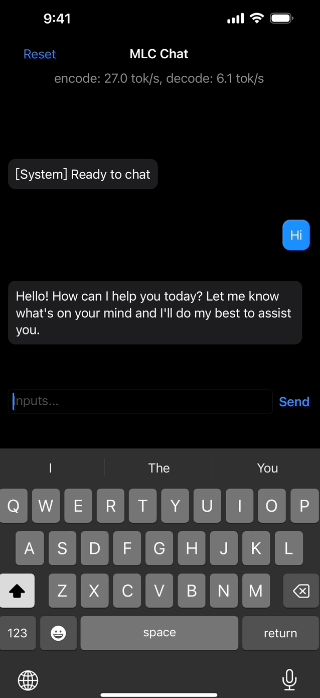

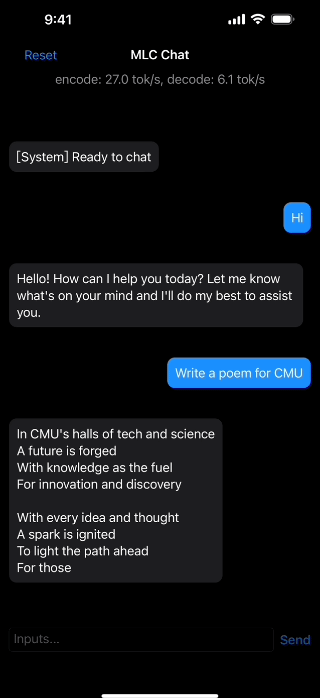

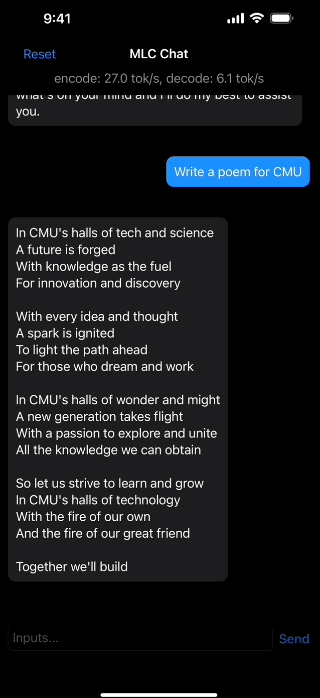

目前主流的 AI 聊天模型都需要服务器训练联网来使用,但是现在 MLC LLM 一个免费开源本地 AI 人工智能聊天项目上线,它主要是可以在本地运行,无需服务器支持,支持用电脑或者手机的 GPU 加速运行。对于 NVIDIA GPU 用户,请确保安装 Vulkan 驱动程序,因为 CUDA 驱动程序可能不好。

极客 AI 了解到,目前 MLC LLM 提供了 Windows、Linux、macOS、iOS 的客户端支持,但是暂无安卓版,相信后续也会有。另外值得一提的是,根据官方说明,只在 iPhone 14 Pro Max 和iPhone 12 Pro 上测试了 MLC LLM,因为需要 6G 的运存甚至更高才能保证顺利使用。

模型介绍

MLC LLM 项目开发团队来自卡内基梅隆大学的 Catalyst 计划、SAMPL 机器学习研究小组以及华盛顿大学、上海交通大学和 OctoML 等。使用了基于 Meta 开发的 LLaMA 模型轻量级 Vicuna-7B-V1.1。不过目前来看效果不如 Open AI 的 GPT3 和 GPT4。

Merlin - 可免费使用 ChatGPT 的浏览器扩展插件

Merlin - 可免费使用 ChatGPT 的浏览器扩展插件 360 智脑 - AI 智能聊天机器人 / 360 大语言模型

360 智脑 - AI 智能聊天机器人 / 360 大语言模型 ChatChat - 支持主流的 AI 聊天 API (OpenAI/Azure/Claude)

ChatChat - 支持主流的 AI 聊天 API (OpenAI/Azure/Claude) 讯飞星火 - AI 智能聊天机器人 / 星火认知大模型

讯飞星火 - AI 智能聊天机器人 / 星火认知大模型 Claude - 免费 AI 人工智能聊天(ChatGPT代替品)

Claude - 免费 AI 人工智能聊天(ChatGPT代替品)